Meta está desarrollando un nuevo prototipo de Inteligencia Artificial de moderación, Few-Shot Learner, que acortaría el tiempo de respuesta frente al contenido malicioso.

PUBLICIDAD

Es un nuevo intento de la empresa antes conocida como Facebook para atacar los problemas más comunes de las redes sociales, como al desinformación y el discurso de odio.

El grupo de investigación de Inteligencia Artificial de Meta, antes conocido como FAIR, trabaja en esta tecnología más generalizada.

“Al identificar el contenido evolutivo y dañino de manera mucho más rápida y precisa, FSL tiene la promesa de ser una pieza crítica de tecnología que nos ayudará a continuar evolucionando y abordando el contenido dañino en nuestras plataformas”, apunta la empresa en su blog de IA.

Few-Shot Learner se basa en un sistema generalizado de aprendizaje, a diferencia del aprendizaje normal con Inteligencia Artificial. Lo explica el blog:

- Primero, se entrena en miles de millones de ejemplos de lenguaje genérico y código abierto.

- Posteriormente el entrenamiento apunta a datos específicos de integridad que se etiquetaron a lo largo de los años.

- En última instancia, se entrena en texto condensado que explica una nueva política.

La forma de entrenamiento de Few-Shot Learner, de Meta

De acuerdo con el blog, Few-Shot Learner “está preentrenado tanto en el lenguaje general como en el lenguaje específico de la integridad, para que pueda aprender el texto de la política implícitamente”.

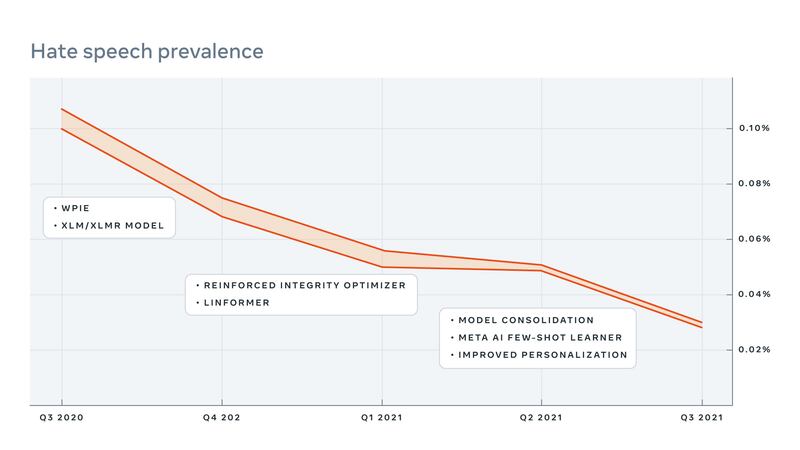

Las pruebas del sistema son positivas. Según los investigadores de Meta, se analizó la prevalencia del contenido dañino en Facebook e Instagram, antes y después de la activación de FSL en los sitios.

PUBLICIDAD

El FSL halló contenido que los modelos convencionales pasaron por alto, reduciendo la prevalencia de ese contenido en general. Superó a otros modelos en un 55%, y en promedio en un 12%.

“Estamos trabajando activamente en problemas clave de investigación abierta que van más allá de la comprensión del contenido solamente, y tratamos de inferir el contexto cultural, conductual y conversacional que lo rodea”, explica Meta en su blog.

El ejemplo de los conejitos

Meta plantea un ejemplo básico para diferenciar los sistemas convencionales del novedoso FSL.

- El sistema convencional entrena a su Inteligencia Artificial con cientos de miles de fotos de conejos, llevándolo al conjunto de prueba con la pregunta “¿Son estas dos imágenes de conejos?”. En algún momento, alguno de los conejos puede no ser reconocido, por lo que el sistema falla.

- El modelo FSL aprende qué es el conejo y por qué afecta la política de la compañía: así reconoce más ampliamente el contenido dañino cuando lo ve, porque entiende cuál es la política que el contenido viola. Es lo que se denomina implicación.

“Nuestra visión a largo plazo”, señala Meta, “es lograr flexibilidad y eficiencia de aprendizaje similar a la humana, haciendo que nuestros sistemas de integridad sean aún más rápidos y fáciles de entrenar y más capaces de trabajar con nueva información”.

Para la empresa de Mark Zuckerberg, “en sistema de IA enseñable como Few-Shot Learner puede mejorar sustancialmente la agilidad de nuestra capacidad para detectar y adaptarnos a situaciones emergentes”.