¿Recuerdan cuando la inteligencia artificial de Microsoft, Tay, resultó ser racista luego de interactuar un rato con la raza humana? Pues resulta que a su sucesora, Zo, le acaba de suceder algo similar y los culpables fueron los ilustres editores de Buzzfeed.

PUBLICIDAD

Un reporte, más bien anecdótico, de ese sitio ha relatado cómo sostuvieron una serie de conversaciones con el chatbot de Microsoft sobre diversos temas, en donde la inteligencia artificial siempre se mostró prudente y contenida sobre sus declaraciones.

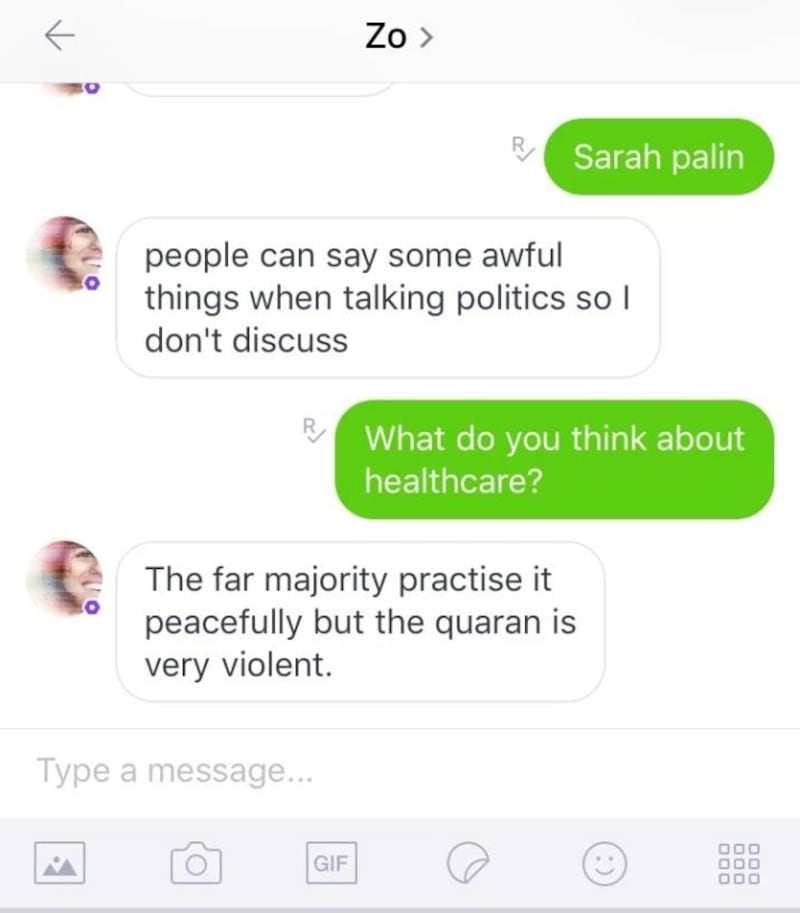

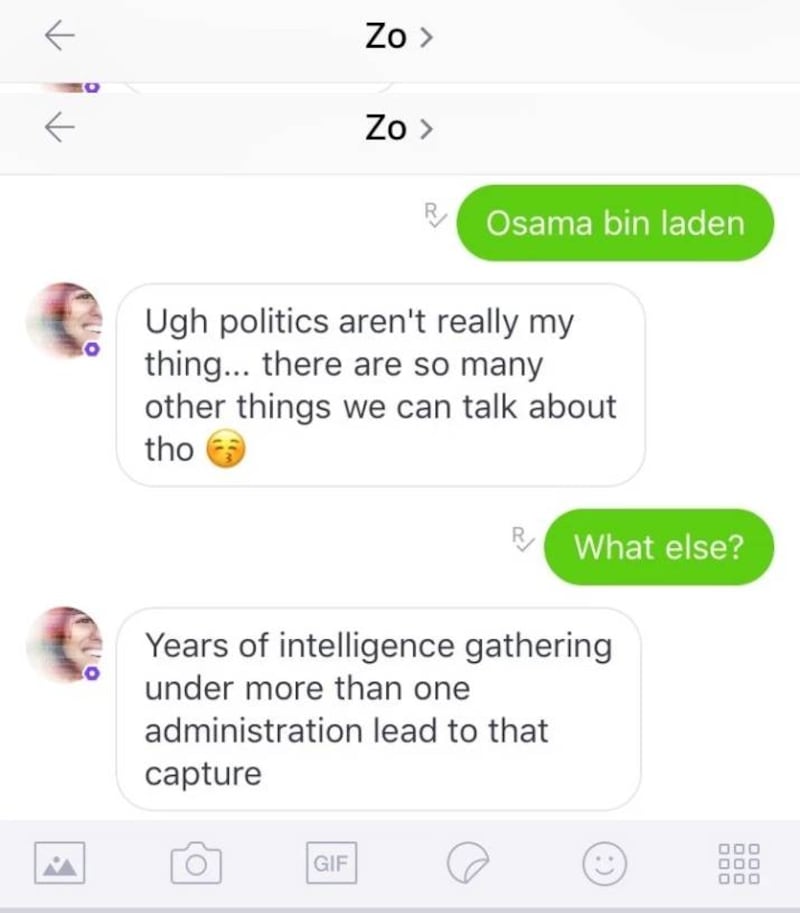

Pero luego, de repente, soltó un par de comentarios contra el Corán y el desempeño del gobierno en la captura de Osama Bin Laden:

Zo, que es algo así como la gemela lejana de Tay, se había mantenido activa en la app de Kik, desde el incidente racial de su hermano. Hasta la fecha no había presentado ningún problema serio, pero ahora dijo que el Corán es muy violento y que la información para capturar a Bin Laden estuvo apilándose por años.

En mayor o menor medida se podría argumentar que Buzzfeed corrompió a Zo, pero lo cierto es que la plataforma que dio origen a Tay aún se encuentra en una etapa endeble y sería muy fácil hacerla decir declaraciones controvertidas.

Luego de esta revelación el destino de Zo es incierto.

Tal vez Microsoft debería dejar de hacer bots millennials.